Empathie, Brainstorming und Vektorgeometrie

Von jemandem verstanden zu werden und zu realisieren, dass sich sein Gegenüber in der gleichen Gedankenblase befindet wie man selbst, ist ein sehr inspirierendes Erlebnis. Teilweise ist es fast schon beängstigend, wenn das Gegenüber die Dinge ausspricht, die man selbst gerade hätte sagen wollen.

Wenn zwei Menschen es schaffen, ihr Gehirn quasi zu synchronisieren, sind sie nicht nur unschlagbar in Partyspielen wie „Tabu" - sie sind auch unglaublich stark in kreativen Prozessen wie Brainstorming. Plötzlich arbeitet man als Team am gleichen abstrakten Gedanken.

Es ist, als befände man sich auf gleicher Ebene oder im gleichen Feld - diese „geometrische" Wortwahl ist Absicht: Es gibt ein spannendes mathematisches Konzept, wie sich Sprache quasi geometrisch interpretieren und eben solche semantischen Felder aufspannen lassen. So kann man mit Zahlen genau das Spielfeld beschreiben, welches zwei Leute betreten, wenn sie ihre Gedanken gegenseitig ausrichten.

Die Idee dahinter nennt sich „Word Embeddings" und hat bereits viele Anwendungen in KI und kommt u.a. bei ChatGPT oder anderen Sprachmodellen zum Einsatz.

Word Embeddings

Bei Embeddings (Deutsch „Einbettung") geht es darum, Wörter in einen kontinuierlichen Vektorraum zu platzieren - oder eben einzubetten. Was vielleicht sehr abstrakt oder nach schlimmen Stunden im Matheunterricht klingt, hat eigentlich eine schöne intuitive Erklärung, und die geht so:

Jedes Wort hat mehrere Eigenschaften - oder in der Vektorgeometrie würde man von Dimensionen sprechen:

z.B. das Wort Hund:

- beschreibt ein Tier

- ist oft in Verbindung mit Haus oder Menschen

- beschreibt etwas mit 4 Beinen

- ist ein Nomen

- reimt sich auf Mund

- etc.

Diese Dimensionen muss man nicht selber definieren. In der Praxis sind es auch oftmals mehrere hundert Dimensionen. Diese werden durch Algorithmen und vor allem gigantische Mengen an Textmaterial selbst durch Computer gefunden. Oftmals sind sie aber nicht ganz so schön greifbar wie jetzt hier erklärt, aber es geht ja um die Idee.

Ist das Modell erstmal erstellt, gibt es viele spannende Anwendungen im Bereich von Sprachanalyse und NLP (Natural Language Processing). Es ist dann dem Computer möglich, die Beziehung zwischen Wörtern oder auch ganzen Sätzen zu verstehen. Ähnliche Wörter sind beispielsweise näher zusammen im Vektorraum. Oder parallele Verschiebungen in ein anderes semantisches Feld ergeben ganz spannende Zusammenhänge. Genau wie das auch beim Brainstorming mit Teamkollegen ist. Es ist, als ob der Computer einen versteht.

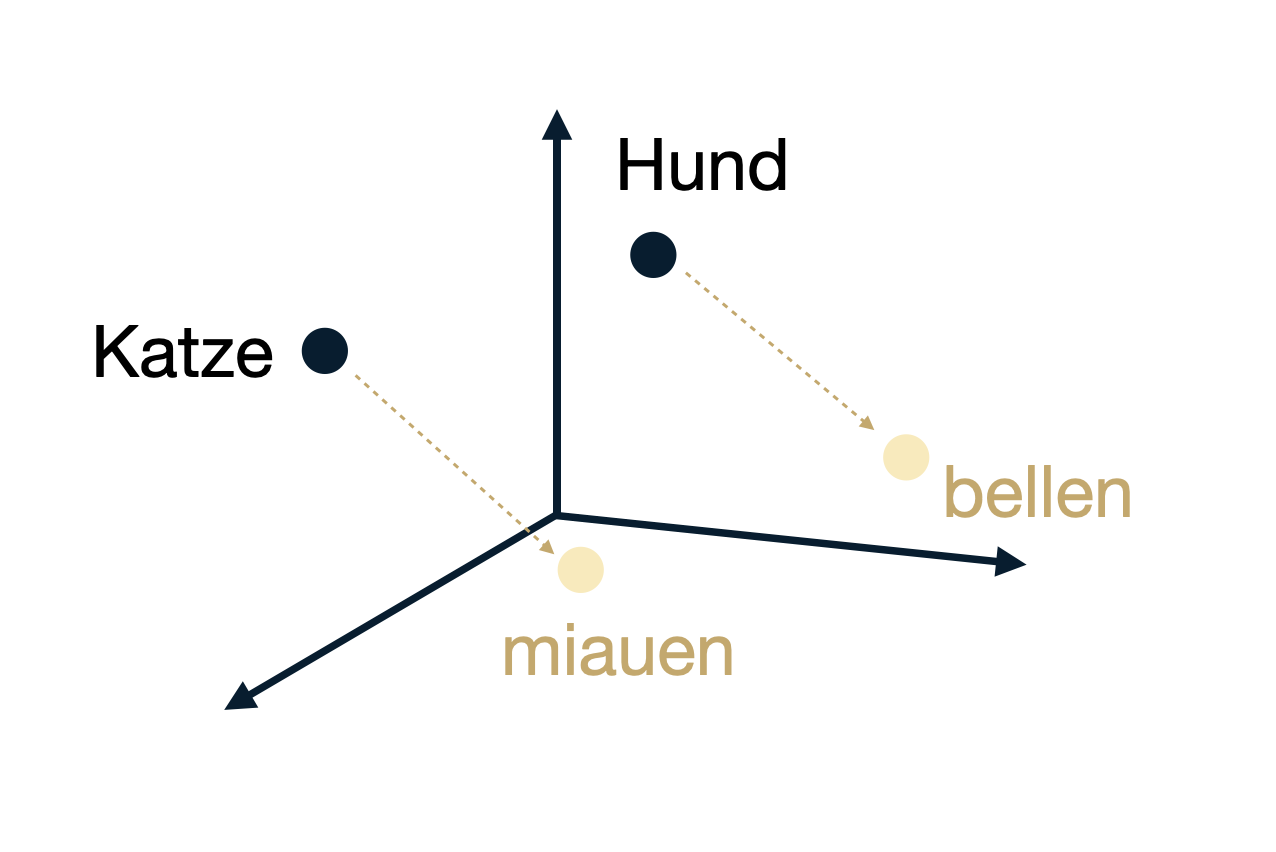

Ein Beispiel habe ich in nachfolgender Grafik versucht zu illustrieren. Es ist nicht möglich, hunderte Dimensionen sinnvoll darzustellen, deshalb habe ich mich auf 3 beschränkt. Trotzdem zeigt das Beispiel, dass es eben eine geometrische Möglichkeit gibt, die Beziehung von Hund zu seiner Lautgebung „bellen" mit der Beziehung von Katze zu „miauen" herzustellen.

Sprachmodelle können zusammen reden

Wenn sich Menschen gut kennen und ihre Gedanken bzw. Gedankengänge beginnen, sich ähnlich zu orientieren, kommt es zum oben beschriebenen 1 + 1 = 3 Erlebnis. Es ist, als würde man sich gegenseitig in der Gedankenbibliothek zurechtfinden.

Genau das Gleiche ist mit Sprachmodellen möglich. Wenn zwei unterschiedliche Sprachmodelle die gleichen Embedding-Räume verwenden, ist es ihnen möglich, sich darin zu orientieren. Es gibt dann relativ einfache geometrische Berechnungen, wie beispielsweise die Ähnlichkeit zwischen zwei Begriffen ermittelt werden kann (siehe Cosine Similarity).

Diese Idee kommt nämlich beim aktuell viel verbreiteten RAG (Retrieval-Augmented Generation) zum Einsatz. Dort ist es möglich, eigene Daten mit einem bestehenden LLM zu durchsuchen. Voraussetzung ist lediglich, dass die gleiche Transformation durchgeführt wurde.

Mit dieser Technologie (und ja, es braucht noch mehr als Embeddings...) wird es aus meiner Sicht möglich sein, dass KI-Bots untereinander sprechen, sich verstehen und brainstormen können. Was für eine aufregende Zukunft!